メカトロニクス制御技術に関連する気になるカタログにチェックを入れると、まとめてダウンロードいただけます。

エッジデバイスへの実装とは?課題と対策・製品を解説

目的・課題で絞り込む

カテゴリで絞り込む

EMC・ノイズ対策技術 |

スマート工場内の搬送系および協働ロボット利活用 |

スマート工場・DX |

パワーエレクトロニクス技術 |

メカトロニクス・制御技術 |

モーション・エンジニアリング |

モータ技術 |

工場内のシステム見える化 |

工場内のデジタルトランスフォーメーション(DX) |

電源システム |

熱設計・対策技術 |

部品加工技術 |

その他メカトロニクス制御技術 |

AI・ディープラーニングにおけるエッジデバイスへの実装とは?

各社の製品

絞り込み条件:

▼チェックした製品のカタログをダウンロード

一度にダウンロードできるカタログは20件までです。

NXP i.MX 8M Plus SoCには最大4つのパワフルな64ビットArmv8 Cortex-A53コアが搭載されており、典型的な産業および医療アプリケーションに十分な電力供給を確保すると同時に最新のグラフィカルユーザーインターフェイスのLinuxを実行する上で、コスト効率に優れた選択肢です。

内蔵されたニューラルネットワークプロセッシングユニット(NPU)は、ディープラーニング推論を実行するためにゼロから設計され、同じ電力範囲のCPUとGPUベースのソリューションの数倍のパフォーマンスを実行

することは出来ます。Toradexは、TensorFlowなど、よく利用される機械学習フレームワークとのインテグレーションを提供します。

「CPUモジュール」 Verdin iMX8M Plus

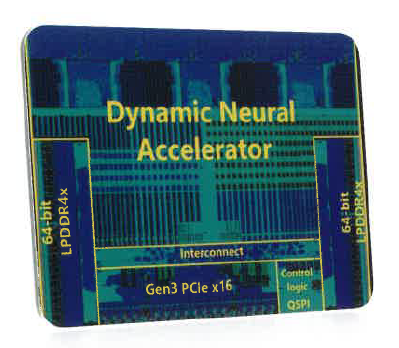

『EdgeCortix SAKURA』は、TSMC 12nm FinFETコプロセッサ(アクセラレータ)で、

業界最高レベルの計算効率とレイテンシを実現するエッジAIコプロセッサSoCです。

SAKURAは、40TOPSのシングルコアであるDynamic Neural Accelerator (DNA)IP

という、全ての計算エンジンをつなぐ再構成可能なデータパスを内蔵した

当社のニューラルプロセッシングエンジンを搭載しております。

ご要望の際はお気軽に、お問い合わせください。

【活かせる産業分野】

■インテリジェントモビリティ/インテリジェント電気自動車

■防衛とセキュリティ

■5G通信

■VR/AR など

※詳しくはPDFをダウンロードしていただくか、お問い合わせください。

エッジAIコプロセッサ『EdgeCortix SAKURA』

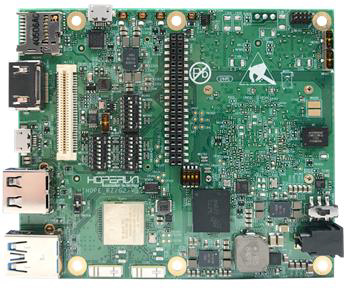

当製品は、ルネサスのメディア処理チップRZ/G2Nを

ベースに開発された評価ボードです。

RZ/G2Nのさまざまな周辺インターフェースだけでなく、

強力なマルチメディア機能のデモにも使用可能。

また、RZ/G2Nに基づくリファレンスハードウェア設計も

提供されており、お客様は製品開発サイクルを短縮できます。

【特長】

■メディア処理チップRZ/G2Nをベースに開発

■強力なマルチメディア機能のデモにも使用可能

■RZ/G2Nに基づくリファレンスハードウェア設計も提供

■製品開発サイクルを短縮できる

■基本的な開発システムを構築可能

※詳しくはPDF資料をご覧いただくか、お気軽にお問い合わせ下さい。

Musashi(RZ/G2N) リファレンスボード

お探しの製品は見つかりませんでした。

1 / 1

AI・ディープラーニングにおけるエッジデバイスへの実装

AI・ディープラーニングにおけるエッジデバイスへの実装とは?

AI・ディープラーニングのエッジデバイスへの実装とは、クラウドサーバーに依存せず、センサーやカメラなどのデバイス自体でAIモデルを動作させる技術です。これにより、リアルタイム処理、低遅延、プライバシー保護、通信コスト削減といったメリットが期待され、製造業における予知保全、自動運転、スマートファクトリーなど、様々な分野での応用が進んでいます。

課題

計算リソースの制約

エッジデバイスは一般的にCPUやメモリなどの計算リソースが限られており、複雑なディープラーニングモデルの実行が困難です。

モデルの最適化と軽量化

限られたリソースで高精度な推論を行うためには、モデルのサイズを小さくし、計算量を削減する高度な技術が必要です。

リアルタイム処理の要求

多くのエッジデバイスでのAI活用は、ミリ秒単位での応答速度が求められるため、遅延の少ない処理が不可欠です。

電力消費の抑制

バッテリー駆動のエッジデバイスでは、AI処理による電力消費の増大が運用上の大きな課題となります。

対策

軽量化モデルの開発

モデル圧縮技術(量子化、枝刈りなど)や、軽量なネットワークアーキテクチャの採用により、モデルサイズと計算量を削減します。

ハードウェアアクセラレーションの活用

AI処理に特化した専用ハードウェア(NPU、GPUなど)をエッジデバイスに搭載し、計算効率を向上させます。

推論エンジンの最適化

エッジデバイスのアーキテクチャに最適化された推論エンジンを使用し、実行速度とリソース効率を高めます。

ハイブリッド型AIアーキテクチャ

一部の処理をエッジで行い、より複雑な処理や学習はクラウドで行うなど、両者の利点を組み合わせたアーキテクチャを採用します。

対策に役立つ製品例

組み込みAIチップセット

AI推論処理に特化した低消費電力・高性能なチップセットが、エッジデバイスでのAI実行を可能にします。

軽量ディープラーニングフレームワーク

エッジデバイスでの動作を前提に設計されたフレームワークが、モデルのデプロイと実行を容易にします。

AIモデル最適化ツール

既存のAIモデルをエッジデバイス向けに軽量化・高速化する機能を提供し、リソース制約を克服します。

エッジAI開発システム

エッジデバイスでのAIモデル開発からデプロイ、管理までを包括的にサポートし、実装プロセスを効率化します。